La inteligencia artificial ha revolucionado industrias, mejorado la eficiencia y transformado la forma en que interactuamos con la tecnología. Sin embargo, a medida que avanza la IA, también lo hacen los riesgos asociados con su mal uso. En 2025, las amenazas de ciberseguridad impulsadas por la IA, las preocupaciones de privacidad, la manipulación de deepfakes y la vigilancia masiva se encuentran en su punto más alto. Si bien la IA también se utiliza para contrarrestar estas amenazas, plantea dilemas éticos en cuanto a regulación, seguridad y libertad personal. Este artículo explora las principales preocupaciones que rodean a la IA y sus implicaciones más oscuras en el mundo moderno.

Hackeo y ciberataques potenciados por inteligencia artificial

Ataques de suplantación de identidad generados por inteligencia artificial.

Los ciberdelincuentes están aprovechando la inteligencia artificial para crear ataques de phishing altamente convincentes. A diferencia de los intentos de phishing tradicionales, que a menudo contienen errores gramaticales y mensajes genéricos, los fraudes de phishing impulsados por inteligencia artificial utilizan el aprendizaje automático para generar correos electrónicos personalizados, mensajes de texto e incluso llamadas de voz deepfake. Estos ataques imitan el tono, estilo de escritura y patrones de habla de contactos de confianza, lo que los hace extremadamente difíciles de detectar. La inteligencia artificial puede analizar la actividad en redes sociales, las conversaciones recientes y los intercambios de correos electrónicos para crear mensajes que parecen legítimos, engañando a las personas para que revelen información sensible como contraseñas, detalles financieros o secretos corporativos.

Malware impulsado por IA

Malware de autoaprendizaje ha surgido como una nueva y peligrosa forma de amenaza cibernética. A diferencia del malware tradicional que sigue un conjunto fijo de instrucciones,AI potenciadoEl malware puede evolucionar continuamente, aprendiendo de su entorno y adaptándose en tiempo real para evadir las defensas de seguridad. Estos virus inteligentes pueden analizar los patrones de antivirus, reconocerciberseguridadPueden modificar sus medidas y su comportamiento para permanecer indetectables. También pueden alterar autonomamente su código para evitar los métodos de detección basados en firmas, lo que hace que los enfoques tradicionales de ciberseguridad sean ineficaces contra estas amenazas en constante cambio.

Ransomware mejorado con inteligencia artificial

Los ataques de ransomware se han vuelto más peligrosos con la introducción de la inteligencia artificial. El ransomware tradicional se basa en algoritmos predefinidos para cifrar archivos y exigir pagos de rescate. Sin embargo, el ransomware mejorado con IA puede explotar vulnerabilidades mucho más rápido, utilizando el aprendizaje automático para identificar puntos débiles en un sistema antes de iniciar un ataque. Una vez dentro de una red, el ransomware impulsado por IA puede propagarse rápidamente, cifrando archivos cruciales mientras deshabilita simultáneamente las medidas de seguridad. Además, estas variantes de ransomware pueden adaptar sus tácticas de negociación, analizando los registros financieros de las víctimas para exigir rescates adaptados a su capacidad de pago, aumentando las posibilidades de extorsión exitosa.

Ataques cibernéticos automatizados

Los hackers están utilizando cada vez más bots impulsados por inteligencia artificial para llevar a cabo ciberataques a una escala nunca antes vista.Inteligencia artificialLos bots pueden escanear redes en busca de vulnerabilidades, ejecutar ataques de fuerza bruta y explotar lagunas de seguridad sin intervención humana. A diferencia de los hackers humanos, los bots de ataque impulsados por IA operan las 24 horas del día, los 7 días de la semana, probando continuamente diferentes vectores de ataque hasta que tienen éxito. Estos ataques automatizados no solo son más rápidos, sino también más difíciles de detectar, ya que cambian constantemente sus estrategias. La capacidad de los bots de IA para atacar múltiples sistemas simultáneamente los convierte en una amenaza significativa, especialmente para organizaciones grandes e infraestructuras críticas.

Contramedidas basadas en IA

Detección de amenazas impulsada por inteligencia artificial.

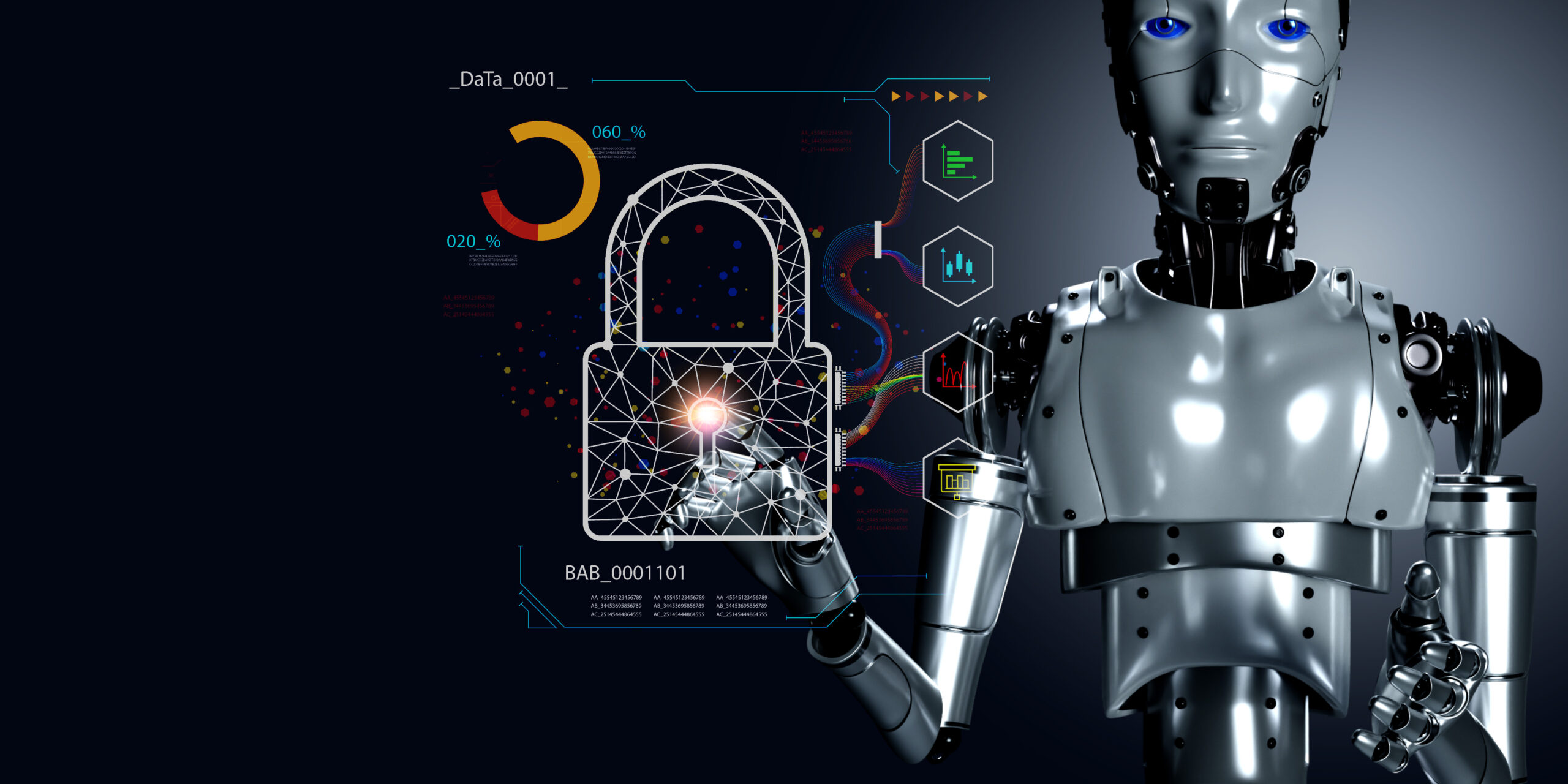

Para contrarrestar las amenazas cibernéticas impulsadas por la IA, los expertos en ciberseguridad están empleando sistemas de detección de amenazas impulsados por IA. Estos sistemas analizan conjuntos de datos masivos en tiempo real, identificando comportamientos inusuales y posibles brechas de seguridad antes de que escalen. Al reconocer anomalías en el tráfico de la red, patrones de inicio de sesión y actividades de usuario, las herramientas de seguridad impulsadas por IA pueden predecir amenazas cibernéticas antes de que ocurran. Además, estos sistemas pueden aprender de ataques pasados y refinar continuamente sus capacidades de detección, lo que los hace más efectivos contra amenazas en evolución.

Detección de ataques de deepfake y IA

El aumento de las amenazas generadas por la inteligencia artificial, como videos deepfake y clones de voz, ha llevado al desarrollo de herramientas avanzadas de detección de IA. Estas herramientas utilizan algoritmos de aprendizaje profundo para analizar detalles minuciosos en contenido digital, como movimientos faciales poco naturales, inconsistencias en patrones de audio y anomalías de píxeles en imágenes. Los sistemas de detección de fraudes basados en IA también pueden identificar identidades sintéticas creadas por IA, previniendo fraudes financieros y campañas de desinformación.tecnologíaA medida que la tecnología se vuelve más sofisticada, estas herramientas de detección se vuelven esenciales para verificar la autenticidad del contenido digital.

Sistemas de ciberseguridad autónomos

La ciberseguridad impulsada por inteligencia artificial se está moviendo hacia la automatización completa, donde los sistemas de IA pueden detectar, responder y neutralizar de forma independiente amenazas cibernéticas en tiempo real. Estos sistemas de seguridad autónomos utilizan algoritmos de IA para monitorear redes, identificar actividades maliciosas y tomar medidas inmediatas, como aislar dispositivos comprometidos, bloquear direcciones IP sospechosas o implementar contramedidas, sin intervención humana. Al eliminar la necesidad de respuestas manuales, estas soluciones de seguridad basadas en IA reducen significativamente los tiempos de reacción, evitando los ciberataques antes de que causen daño. Sin embargo, a medida que las defensas de IA se vuelven más fuertes, los ciberdelincuentes también están mejorando sus métodos de ataque basados en IA, lo que conduce a una carrera armamentista de IA en curso en ciberseguridad.

Riesgos de la Inteligencia Artificial y la Privacidad

Recopilación de datos y violaciones de privacidad La inteligencia artificial depende en gran medida de los datos, y en 2025, la cantidad de información personal recopilada ha alcanzado niveles sin precedentes. Los dispositivos inteligentes, las plataformas en línea y las aplicaciones potenciadas por IA recopilan constantemente datos sobre las preferencias, el comportamiento e incluso los detalles biométricos de los usuarios. Si bien esto permite servicios personalizados, también plantea serias preocupaciones sobre la privacidad. Los usuarios a menudo no son conscientes del alcance de la recopilación de datos, y muchas empresas no proporcionan una transparencia clara sobre cómo se utilizan sus datos.

La publicidad dirigida impulsada por inteligencia artificial se ha vuelto más invasiva, utilizando aprendizaje profundo para predecir las emociones, intereses y vulnerabilidades de los usuarios. Este nivel de personalización permite a las empresas manipular el comportamiento del consumidor, generando preocupaciones éticas sobre la explotación de los datos de los usuarios. Además, los gobiernos y las corporaciones ahora tienen acceso a herramientas de vigilancia impulsadas por inteligencia artificial que rastrean a individuos en espacios públicos, lo que convierte a la privacidad en una preocupación creciente.

Equilibrar la seguridad y la privacidad

Para abordar estos riesgos de privacidad, los investigadores están explorando soluciones como el aprendizaje federado y los modelos de IA descentralizados. El aprendizaje federado permite que la IA se entrene en los datos de los usuarios sin transferirlos a un servidor central, reduciendo el riesgo de violaciones de datos. Mientras tanto, los modelos de IA descentralizados dan a los individuos más control sobre sus datos, limitando cuánta información es almacenada por las corporaciones.

Otro avance importante es el impulso hacia la transparencia y explicabilidad de la IA. A medida que la IA se integra más en la vida cotidiana, hay una creciente demanda de que los modelos de IA expliquen sus decisiones. Por ejemplo, si un sistema impulsado por IA deniega una solicitud de préstamo, el usuario debería entender por qué. Los gobiernos están implementando regulaciones más estrictas para garantizar que las empresas cumplan con estos principios, pero la aplicación sigue siendo un desafío.

IA en Vigilancia y Preocupaciones Éticas

Vigilancia Masiva Potenciada por IA

La vigilancia impulsada por inteligencia artificial se ha vuelto más poderosa que nunca. Los gobiernos y organizaciones privadas utilizan la tecnología de reconocimiento facial para rastrear a individuos en lugares públicos, generando preocupaciones sobre la vigilancia masiva y la pérdida de anonimato. Los sistemas de predicción de comportamiento impulsados por IA analizan patrones de movimiento, actividad en línea e interacciones para determinar posibles amenazas de seguridad, pero dichos sistemas también pueden ser utilizados para un monitoreo y control excesivos.

Uno de los desarrollos más controversiales es el aumento de la aplicación de la ley automatizada. Los sistemas impulsados por inteligencia artificial pueden analizar patrones delictivos e incluso predecir actividades criminales potenciales. Si bien esta tecnología está diseñada para mejorar la seguridad, plantea interrogantes éticos sobre la imparcialidad y el sesgo. Si la IA etiqueta erróneamente a una persona inocente como una amenaza, podría llevar a consecuencias injustas, reforzando los sesgos existentes en la sociedad.

Desafíos éticos de la Inteligencia Artificial en Seguridad

Los sistemas de vigilancia de IA han sido criticados por mostrar sesgos, especialmente en la tecnología de reconocimiento facial. Estudios han demostrado que algunos modelos de IA tienen dificultades para identificar con precisión a individuos de ciertos orígenes étnicos, lo que provoca falsos positivos y acusaciones erróneas. Esto ha generado debates sobre si se deben confiar en las medidas de seguridad impulsadas por IA, especialmente cuando se utilizan en la policía y la seguridad pública.

Otra creciente preocupación es la militarización de la inteligencia artificial. Los drones autónomos, armas impulsadas por IA y sistemas militares predictivos han introducido una nueva era de guerra en la que la IA puede tomar decisiones de vida o muerte. Mientras que los gobiernos argumentan que estas tecnologías mejoran la seguridad nacional, los críticos advierten sobre los peligros de permitir que las máquinas determinen el destino humano. Las implicaciones éticas de la guerra controlada por IA siguen siendo un tema profundamente debatido.

Amenazas de deepfake y desinformación de IA

Cómo los Deepfakes están explotando la inteligencia artificial

La tecnología deepfake ha avanzado al punto en que distinguir contenido real de lo falso se está volviendo casi imposible. Videos generados por inteligencia artificial de figuras políticas, celebridades y personas comunes pueden ser manipulados para propagar información falsa. Esto ha llevado a campañas de desinformación que influyen en la opinión pública, interrumpen elecciones y crean confusión generalizada.

Uno de los usos más preocupantes de los deepfakes es en el fraude financiero y estafas de ingeniería social. Los criminales pueden clonar la voz o imagen de una persona y usarla para engañar a bancos, negocios o incluso a familiares. Con solo unos pocos segundos de audio grabado, la inteligencia artificial puede generar una voz falsa increíblemente realista, haciendo que las medidas de seguridad basadas en la voz sean ineficaces.

Herramientas de IA luchando contra deepfakes y desinformación

Para contrarrestar las amenazas de deepfake, se han desarrollado herramientas de detección con inteligencia artificial para identificar contenido manipulado. Estos sistemas analizan inconsistencias en videos, como movimientos faciales artificiales, errores de iluminación y desajustes de audio. Además, la tecnología blockchain se está explorando como una forma de verificar la autenticidad del contenido de medios, asegurando que los archivos digitales permanezcan a prueba de manipulaciones.

Los gobiernos y las plataformas de redes sociales también están invirtiendo en herramientas de verificación de hechos basadas en inteligencia artificial. Estos sistemas escanean contenido en línea en tiempo real, señalando información falsa y proporcionando contexto para evitar la difusión de desinformación. No obstante, a medida que las técnicas de detección mejoran, los métodos de generación de deepfakes siguen evolucionando, lo que convierte esto en una batalla constante.

Regulaciones de IA y el futuro de la ética de la IA

Políticas del Gobierno y Leyes de Inteligencia Artificial

Reconociendo los posibles peligros de la inteligencia artificial, los gobiernos de todo el mundo están promulgando regulaciones más estrictas. Las nuevas leyes requieren que las empresas revelen cómo funcionan sus modelos de inteligencia artificial, garanticen la equidad en la toma de decisiones y protejan los datos de los usuarios. Las auditorías de cumplimiento de la inteligencia artificial están empezando a ser obligatorias, responsabilizando a las organizaciones por el uso ético de la inteligencia artificial.

Sin embargo, la regulación de la IA es compleja. Mientras que un control excesivo puede obstaculizar la innovación, una regulación insuficiente podría dar lugar a abusos de la IA no controlados. Lograr un equilibrio entre la seguridad y el progreso tecnológico sigue siendo uno de los mayores desafíos de la era de la IA.

El Dilema: Seguridad vs. Libertad

A medida que la IA continúa moldeando la sociedad, surge una pregunta crucial: ¿debería controlarse la IA o debería primar la innovación? Los modelos de IA de código abierto empoderan a los investigadores y desarrolladores, pero también presentan el riesgo de ser utilizados de forma indebida por actores malintencionados. El futuro de la ética de la IA depende de la colaboración global para garantizar que la IA se utilice de manera responsable, manteniendo la libertad y la seguridad.

Conclusión

La inteligencia artificial es tanto una herramienta poderosa para la seguridad como un arma peligrosa para los ciberdelincuentes. La batalla entre las amenazas impulsadas por la IA y las contramedidas basadas en la IA continuará dando forma al futuro. Lograr un equilibrio entre la innovación, la regulación y el uso ético de la IA es crucial para garantizar un mundo digital más seguro y justo.